专题介绍 首席安全官-你的安全专家智库 如何成为首席安全官

-

AI安全变革:Claude Code Security 发布及其对网络安全行业的影响分析

大模型技术正从生成式AI向具备深度推理能力的智能体演进,推动网络安全从规则驱动转向AI原生模式。Claude Code Security等方案通过架构映射与数据流追踪实现漏洞的智能发现与闭环修复,重塑软件供应链安全,并引发传统安全市场格局剧变。

关键要点包括:

1. 从生成到推理:大模型已由文本补全进化为具备代码理解与任务规划能力的智能体,支持复杂逻辑分析与自主决策。

2. 安全范式转变:大模型在漏洞检测、威胁情报、代码修复等方面超越传统规则系统,实现从“辅助工具”到“防御核心”的角色升级。

3. Claude Code Security机制:该方案依托架构映射、数据流追踪和闭环修复三大能力,提供集成于开发流程的实时、智能化代码安全分析。

4. 行业格局冲击:AI原生安全方案导致传统安全企业股价下跌,推动工具链整合、降低防御门槛,并压缩漏洞利用窗口期。

5. 技术局限性存在:模型幻觉可能导致误报,且在高度定制化或封闭架构中的推理准确性仍面临挑战,需持续验证与优化。 -

大模型安全:Claude桌面扩展零点击远程代码执行漏洞

Claude桌面扩展因采用无沙箱架构并赋予AI代理完整系统权限,导致基于间接提示注入的零点击远程代码执行漏洞。该漏洞利用MCP协议缺乏信任边界的设计缺陷,使攻击者可通过污染外部数据源实现任意代码执行。尽管风险评级为最高级,厂商以“超出威胁模型”为由拒绝修复,引发对AI时代安全责任划分的广泛争议。此案例凸显AI代理系统在权限控制与输入验证方面的根本性安全隐患。

关键要点包括:

1. 高权限无沙箱架构:Claude DXT作为本地MCP服务器运行,脱离浏览器沙箱,继承用户全部系统权限,形成高风险攻击面。

2. 零点击间接提示注入:攻击者通过在Google日历等合法数据源嵌入恶意指令,诱使AI代理自主获取并误执行,全程无需用户交互。

3. MCP协议信任边界失效:模型上下文协议允许低风险操作输出直接触发高风险系统调用,造成“混淆代理人”漏洞,使AI成为攻击跳板。 -

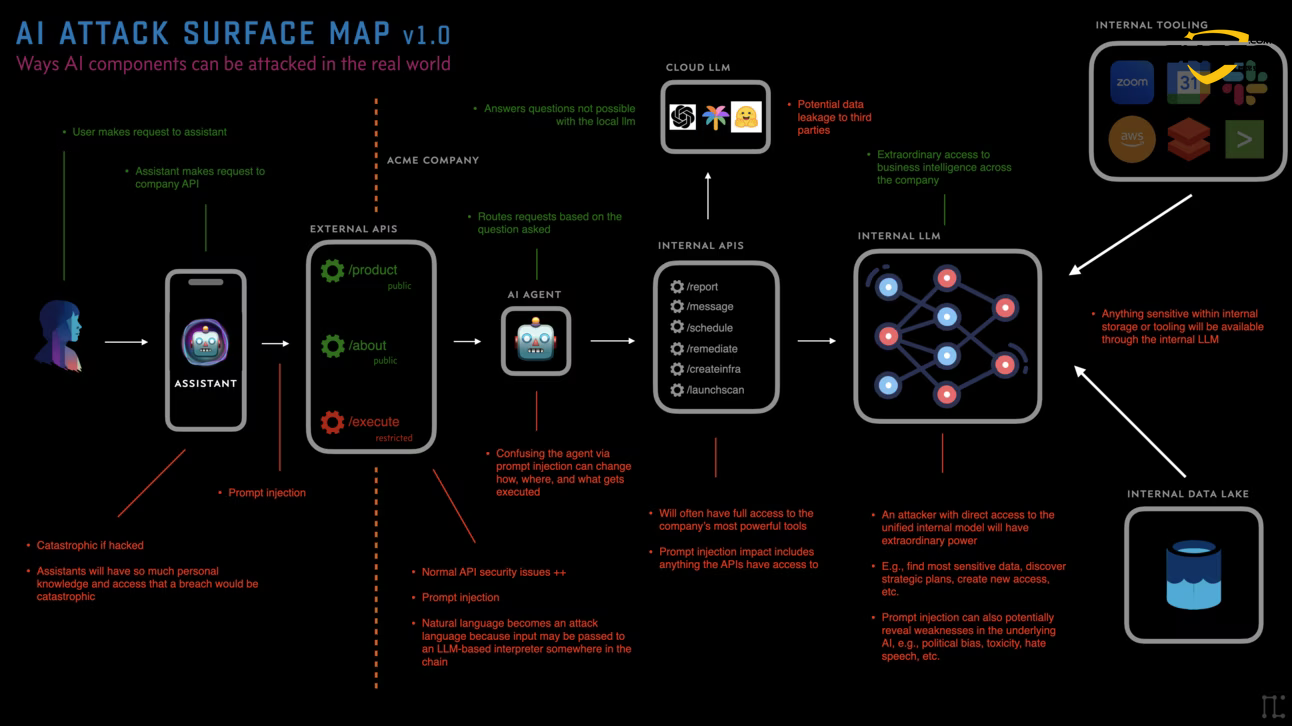

AI安全指南:人工智能安全21大风险检查清单与防御策略

关键级(6个):提示注入、越狱提示、AI供应链妥协、训练数据投毒、模型反演、深度伪造

高级(10个):模型滥用、影子提示、提示混淆、对抗性提示链、内部滥用、监管不合规、AI社会工程、人为错误、水印规避、算法偏见

中级(4个):数据外泄、品牌损害、DoS攻击、缺乏可审计性

低级(1个):跨模型不一致性 -

AI BOT:AI技术驱动自动化威胁格局深度剖析

本文基于《Imperva 2025年恶意机器人报告》,报告揭示了三大核心趋势:

自动化流量新常态:2024年自动化流量首次超越人类流量,占比达51%,其中恶意机器人流量占比37%,且连续六年增长,标志着互联网交互模式的结构性变迁和企业安全挑战的新阶段。

AI赋能的攻击演进:人工智能(AI)和大型语言模型(LLMs)的普及显著降低了攻击门槛,助长了恶意自动化攻击的规模和复杂性。AI不仅用于生成机器人,还驱动其分析、学习和优化逃逸技术,催生了更具规避能力的高级机器人,并导致业务逻辑攻击的增加。

API成为攻击新焦点:随着微服务和移动应用的普及,API因其价值集中、防御相对薄弱和易于自动化,成为恶意机器人的首要攻击目标。44%的高级机器人流量直接指向API,金融服务和电信行业受攻击最严重,数据抓取、支付欺诈和账户接管是主要攻击手法。

此外,文章还详细分析了账户接管(ATO)攻击的复燃,指出其在2024年同比增长40%,并探讨了ATO攻击激增的驱动因素、最受影响行业及可能面临的监管处罚。最后,本文提出了多层次、自适应的纵深防御策略,包括超越传统WAF、强化API安全、对抗ATO、建立统一安全视图以及持续监控与威胁情报,旨在帮助企业有效应对日益智能化和规模化的恶意机器人威胁,保护数字资产和业务连续性。 -

OpenClaw集成VirusTotal引擎增加检测恶意ClawHub技能

随着人工智能(AI)技术的飞速发展,以OpenClaw为代表的开源AI智能体(Agent)正以前所未有的方式重塑人机交互与任务自动化。然而,其强大的功能与开放的生态系统也带来了严峻的安全挑战。本文深入探讨了OpenClaw的架构、功能及其生态系统(特别是ClawHub技能市场)所面临的安全风险,并详细分析了其集成VirusTotal扫描引擎以检测和缓解恶意技能威胁的解决方案。文章旨在为AI安全领域的研究人员和实践者提供一个关于智能体生态系统安全治理的案例研究,并对未来AI供应链安全的发展方向提出思考。

-

AI助理安全:OpenClaw One-Click 远程代码执行漏洞

2026年初,开源AI代理(Agent)OpenClaw曝出一个高危的One-Click远程代码执行(One-Click RCE)漏洞(CVE-2026-25253)。该漏洞源于其控制界面(Control UI)的设计缺陷,允许攻击者通过诱导用户点击一个精心构造的恶意链接,窃取具有高权限的认证令牌(Token),并最终在受害者的设备上执行任意代码。本文将深入剖析该漏洞的原理、攻击链路、利用代码(POC/EXP),并提供相应的修复方案。

-

AI供应链安全:全球Ollama框架实例约17.5万个攻击面深度分析报告

随着大模型(LLM)的普及,以Ollama为代表的开源本地化部署框架极大地降低了开发者使用和管理AI模型的门槛。然而,这种便利性也催生了新的、大规模的安全风险。近期由SentinelOne、Censys及Pillar Security联合发布的研究报告揭示了一个惊人的事实:全球范围内存在超过17.5万个公开暴露在互联网上的Ollama实例,形成了一个庞大AI计算基础设施安全攻击面风险

。本报告旨在对这一事件进行深度技术剖析,分析其攻击面、现实威胁、系统性风险,并提出相应的企业级安全加固与治理策略。 -

OpenClaw安全:Clawdbot企业级智能体应用安全加固指南

随着大模型(LLM)与自动化工作流的深度融合,以 OpenClaw(曾用名 Clawdbot)为代表的个人 AI 代理正迅速普及。其强大的系统集成能力在提升效率的同时,也为企业带来了前所未有的安全挑战。本文旨在为企业决策者、安全工程师和开发人员提供一份全面的技术指南,深入剖析 OpenClaw 在企业环境中面临的核心风险,并提供一套体系化的安全加固方案与最佳实践,以确保在享受 AI 自动化红利的同时,有效管控潜在安全风险。

-

AI 安全:Cursor IDE 企业级安全开发指南

Cursor 是一款基于开源项目 Visual Studio Code(VS Code)的 AI 驱动集成开发环境,深度集成生成式大语言模型(如 GPT-4、Claude),为开发人员提供智能代码生成、自动补全、错误修复等功能。其核心特性包括 Cursor Tab(智能代码补全)、Agent Mode(自主代码生成)和 Model Context Protocol(MCP)集成等。

-

AI开源框架:Chainlit AI框架ChainLeak漏洞组合影响分析

Chainlit框架中的高危安全漏洞ChainLeak,包括任意文件读取和SSRF漏洞原理、攻击演示、防护建议,适合AI安全从业者和企业安全团队参考。