Описание

Вы столкнулись с проблемой при создании и редактировании файла robots.txt на вашем сайте?

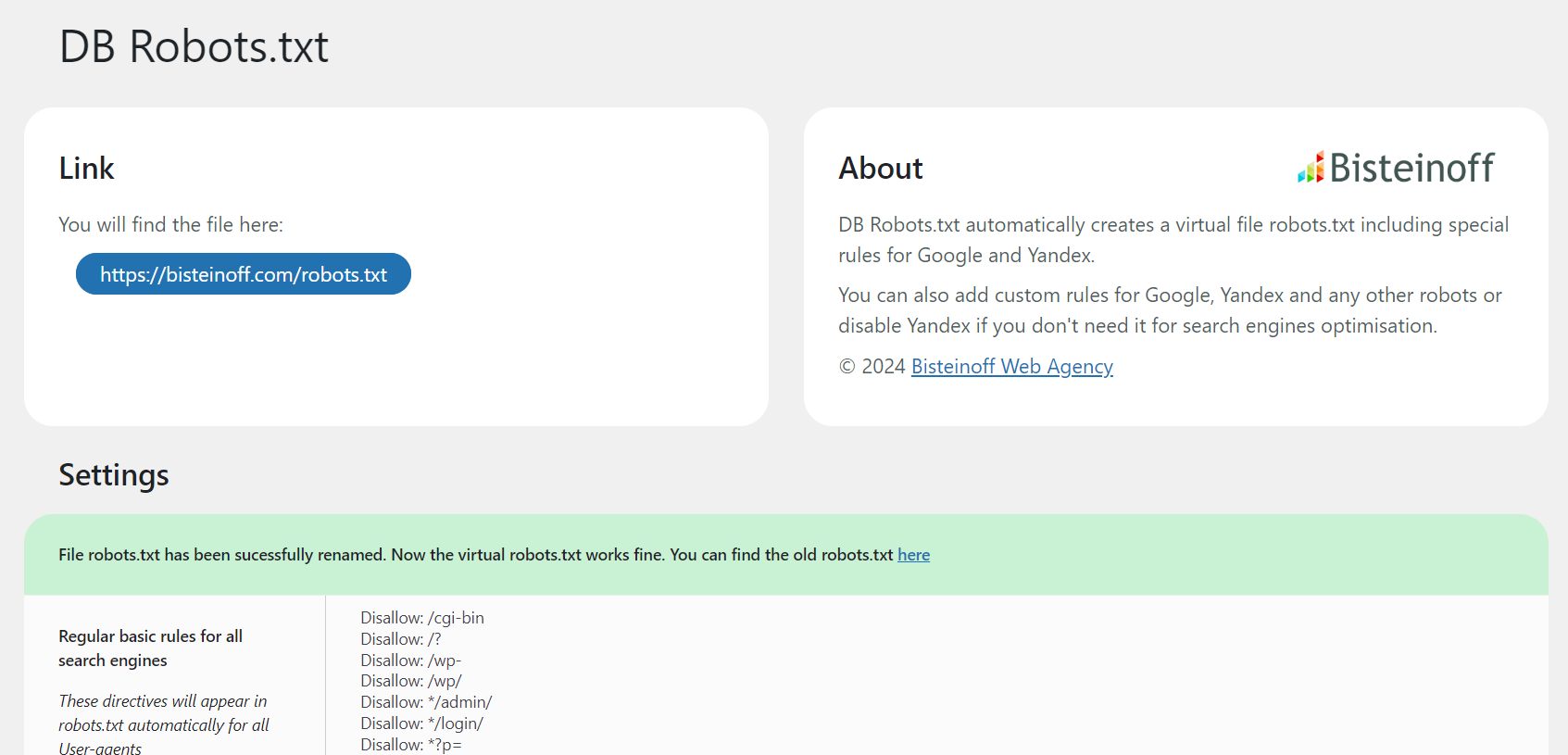

Bisteinoff SEO Robots.txt is an easy-to-use plugin that helps you generate and configure a correct robots.txt file, which is essential for search engine optimization (SEO). This file defines crawling rules for search engine bots such as Google, Bing, Yahoo!, Yandex, and others.

Плагин прекрасно работает как в том случае, если файл robots.txt никогда не создавался, так и в том случае, если он уже существует. После установки плагин создает оптимизированный файл robots.txt, который включает специальные правила, общие для веб-сайтов на WordPress. После этого вы можете продолжить дальнейшую настройку с учетом особенностей вашего веб-сайта, если это необходимо.

Если плагин обнаружит один или несколько файлов Sitemap XML, он добавит их в файл robots.txt.

FTP-доступы не требуются, не нужно писать код или редактировать файл, это делает управление настройками простым и удобным!

Key Features

- Automatic generation of optimized robots.txt with WordPress-specific rules

- Special rules for Google and Yandex search engines

- Custom rules support for any search engine bot

- Automatic sitemap detection and inclusion

- WooCommerce compatibility with specific rules

- Multisite support

- Easy-to-use admin interface

- Modern PHP architecture with namespaces for conflict-free operation

Скриншоты

Установка

- Загрузите папку db-robotstxt в каталог

/wp-content/plugins/ - Активируйте плагин через меню «Плагины» в WordPress

- The plugin will automatically create a virtual robots.txt file

- Go to Settings > SEO Robots.txt to customize rules

Часто задаваемые вопросы

-

Будет ли конфликт с существующим файлом robots.txt?

-

No, it will not. If the file robots.txt is found in the root folder it will not be overridden. On the Settings page you will see a notification with two options: rename or delete the existing file robots.txt. The plugin provides this functionality directly in the admin interface.

-

Could I accidentally block all search robots?

-

Once the plugin is installed it will work fine for all search engine robots. If you are not aware of the rules for fine-tuning a robots.txt it is better to leave the file as is or read first a corresponding manual to learn more about the directives used for robots.txt.

Примечание: следующие директивы заблокируют соответствующих поисковых роботов:

Disallow: Disallow: / Disallow: * Disallow: /* Disallow: */You should use any of these directives only if you do not want any page of your website to be accessible for crawling.

-

Where can I read the up-to-date guide on robots.txt?

-

What happens when I update to version 4.0?

-

For regular users: Nothing changes! The plugin will automatically migrate all your settings. Everything continues to work exactly as before.

For developers: Version 4.0 introduces a complete code refactoring with modern PHP classes and namespaces. If you have custom code that references this plugin’s functions, constants, or options, please review the migration information below.

-

Migration to v.4.0 — Information for Developers

-

If you have custom code that integrates with this plugin, please note these changes:

Checking for deprecation notices: All deprecated elements will trigger

_doing_it_wrong()notices whenWP_DEBUGis enabled. Enable debug mode to identify any issues:

define(‘WP_DEBUG’, true);Changed option names:

*db_robots_custombisteinoff_plugin_robots_custom

*db_robots_custom_googlebisteinoff_plugin_robots_custom_google

*db_robots_if_yandexbisteinoff_plugin_robots_enable_yandex

*db_robots_custom_yandexbisteinoff_plugin_robots_custom_yandex

*db_robots_custom_otherbisteinoff_plugin_robots_custom_otherNote: Options are migrated automatically. Old option names are removed from the database after successful migration.

Changed constants:

*DB_PLUGIN_ROBOTSTXT_VERSIONBISTEINOFF_PLUGIN_ROBOTS_VERSION

*DB_PLUGIN_ROBOTSTXT_DIRBISTEINOFF_PLUGIN_ROBOTS_DIRNote: Old constants remain defined for backward compatibility.

Changed functions (now deprecated):

*publish_robots_txt()Use\Bisteinoff\Plugin\RobotsTXT\Generator::generate()instead

*db_robots_admin()Use\Bisteinoff\Plugin\RobotsTXT\Admin::add_menu_page()instead

*db_robotstxt_admin_settings()Use\Bisteinoff\Plugin\RobotsTXT\Admin::render_settings_page()instead

*db_settings_link()Use\Bisteinoff\Plugin\RobotsTXT\Loader::add_settings_link()insteadNote: Deprecated functions continue to work with backward compatibility.

Action required:

Update your custom code to use the new naming conventions. All deprecated elements will be removed after Feb 16th 2027.

Отзывы

Участники и разработчики

«Bisteinoff SEO Robots.txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники«Bisteinoff SEO Robots.txt» переведён на 5 языков. Благодарим переводчиков за их работу.

Перевести «Bisteinoff SEO Robots.txt» на ваш язык.

Заинтересованы в разработке?

Посмотрите код, проверьте SVN репозиторий, или подпишитесь на журнал разработки по RSS.

Журнал изменений

4.0

- MAJOR UPDATE: Complete code refactoring with modern PHP architecture

- Compatible with WordPress 6.9

- Compatible with WordPress Theme Bisteinoff 2.4+

- Compatible with PHP 7.0 through PHP 8.4 (no deprecated PHP features used)

- Feature: Modern PHP namespaces (

Bisteinoff\Plugin) to prevent conflicts with other plugins - Feature: Seamless integration with Bisteinoff WordPress themes and plugins

- Feature: Efficient class-based architecture with lazy loading

- Feature: Automatic migration system for settings and options

- Fix: Undefined variable warnings for

$db_renamedand$db_deleted - Backward Compatibility: All old function names preserved until at least February 16, 2027

- Backward Compatibility: Old constant names (DB_PLUGIN_ROBOTSTXT_*) preserved

- Backward Compatibility: Options automatically migrated from old to new names

- For Developers: See FAQ section «Migration to v.4.0» for detailed technical information

3.12

- Compatible with WordPress 6.7

- Переписан код с устаревшими и нерекомендуемыми функциями

- Вопросы безопасности

3.11

- Дизайн страницы настроек в админ панели

3.10

- Пользовательские правила для WooCommerce, если этот плагин установлен и активирован

- Исправление проблемы с амперсандом

3.9

- Вопросы безопасности

3.8

- Compatible with WordPress 6.5

3.7

- Вопросы безопасности

3.6

- Compatible with WordPress 6.3

- Вопросы безопасности

3.5

- Совместим с мультисайтами

3.4.2

- Исправлены ошибки в функциях перевода плагина

3.4.1

- Теперь переводы автоматически загружаются с https://translate.wordpress.org/projects/wp-plugins/db-robotstxt/ Если перевода на ваш язык нет, пожалуйста, помогите его сделать!

3.4

- Совместим с GlotPress

3.3

- Новые возможности для переименования или удаления существующего файла robots.txt

3.2

- Новая возможность отключить правила для Yandex

- Дизайн страницы настроек в админ панели

3.1

- Новые базовые регулярные правила для Googlebot и Yandex

- Теперь больше возможностей для управления файлом robots.txt: вы можете добавлять собственные правила для Googlebot, Yandex и других User-agent

- Дополнительная информация о вашем robots.txt на странице настроек

3.0

- Добавлена страница настроек в админ панели для пользовательских правил

2.3

- Протестировано с WordPress 6.2.

- Оптимизирован код

- Добавлены директивы для новых типов изображений WebP, Avif

2.2

- Скорректирована опция Sitemap

2.1

- Протестировано с WordPress 5.5.

- Добавлен wp-sitemap.xml

2.0

- Протестировано с WordPress 5.0.

- Устаревшая директива Host удалена, так как больше не поддерживается Яндексом.

- Директивы robots.txt улучшены и актуализированы.

- Добавлены директивы robots.txt, запрещающие индексирование дублирующихся страниц с метками UTM, Openstat, From, GCLID, YCLID, YMCLID

1.0

- Первый релиз