生成AIと漫画/ChatGPT o3とMidjourney v7で漫画スタイルの開発 - Blog 2025/05/04

COLORSプロジェクトでは、学習データが告示されていない画像生成AIモデルでイラスト表現の生成(作品化)は実行しないという方針だったので、漫画やイラストレーション領域の検証はほとんどやっていませんでした。

3~4月にLLMの性能が飛躍的に向上したことで、ビジュアルのスタイル開発にも十分活用できるようになり(今回初めて)漫画スタイルの検証も実施しました。

検証内容の一部をメモしておきます。

使用したのは、ChatGPT 4o / o3です。

画像生成AIモデルは、Midjourney v7を使いました。

開発するプロンプトの構造は「Subject + Scene + Style」で、ChatGPT 4o / o3を使用するのは「Style」の部分です。

まず、Midjourney v7でランダムに生成したイラスト/漫画表現の画像の中から検証対象を選び、ChatGPT o3で分析させることから始めました。

分析結果に沿って画像生成用のプロンプトを生成させます。

この画風制御プロンプトでChatGPT o3に絵を生成させます。

条件を与えてアングルを変更。

描き込みのレベルを変更して生成。

以下が、ChatGPT o3による画風分析(プロンプト化)です。これが、たたき台となり、必要に応じてChatGPT o3に戻して再分析を繰り返します。

画風制御プロンプトが完成するまでに、概ね3~6回くらいのイテレーションが必要です。

画風制御プロンプト(初期):

Ultra-detailed black-and-white manga illustration, professional seinen style. Thick bold outline combined with ultra-fine interior linework, expressive sparkling eyes, delicate cross-hatching and screentone dot shading for soft gradients, soft blush on cheeks, flowing hair strands with ink splatter accents, minimal background of diagonal floor tiles, high contrast, crisp digital pen-and-ink finish, particles of white ink floating in the air. 8k resolution, no color, no watermark.

ChatGPT o3で開発した画風制御プロンプトを複数の画像生成AIモデルで試します。

Gemini(Imagen 3)で使用した結果です。

Adobe Firefly Image 4は、かなり良くて忠実に画風を再現しています。

※旧バージョンのFirefly Image 3はまったく効きません(表現のレベルが低い)。

Firefly Image 4のイラスト表現はけっこう優秀。

ChatGPT o3で開発した画風制御プロンプトが良く効いています。

今回は、Midjourney v7を使用します。

Midjourneyはパラメータが他の画像生成AIモデルより多く、プロンプトを壊さず、様々なバリエーションを生成できるため、検証には都合が良い。

画風制御プロンプトに、被写体プロンプトを追加しながら進めていきます。

プロンプト構造「Subject + Scene + Style」の「Style」が画風制御プロンプト、「Subject」が被写体プロンプトです。今回は「Scene」を省略していますのでランダムな背景になります。

被写体プロンプト:

Super cute young woman.

被写体プロンプト:

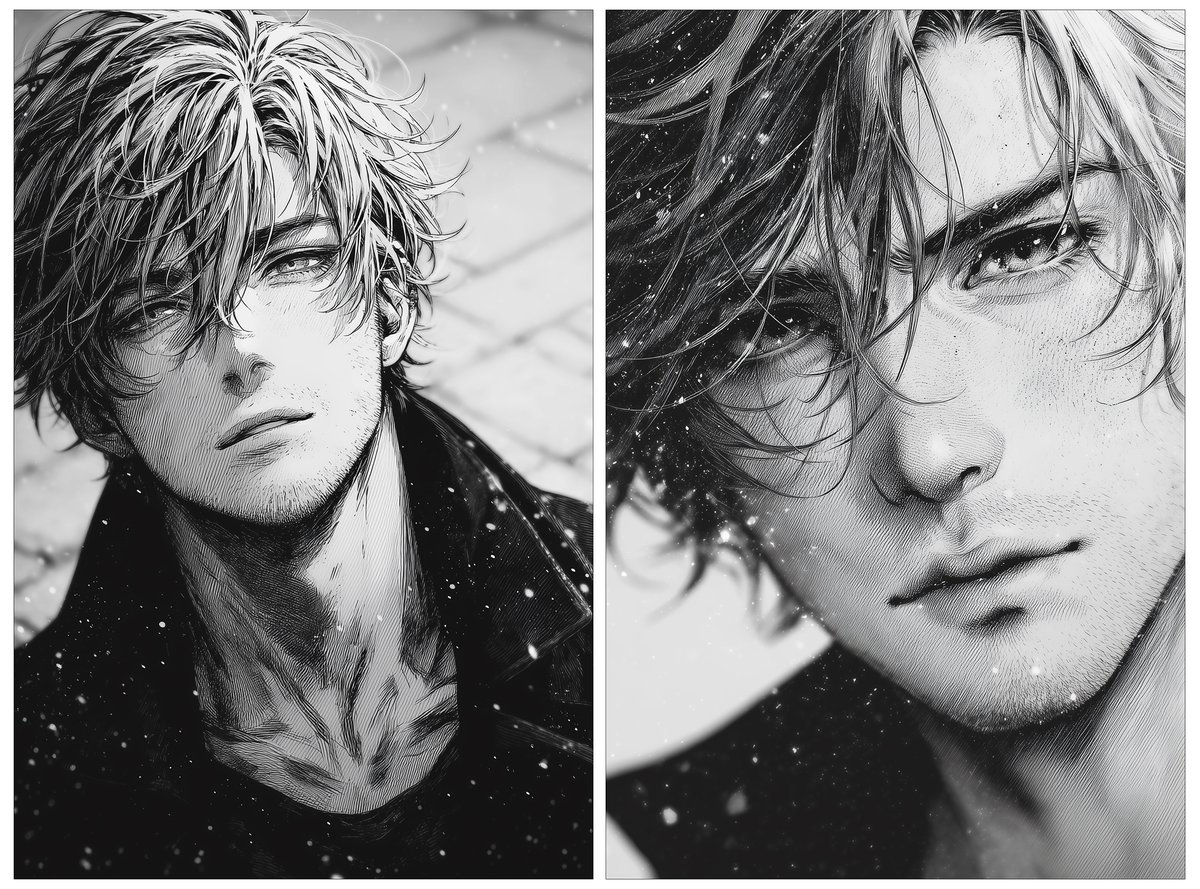

Super cool young man.

プロンプトは全く変更していませんが、パラメータを値を操作しているので、画風が変化しています。

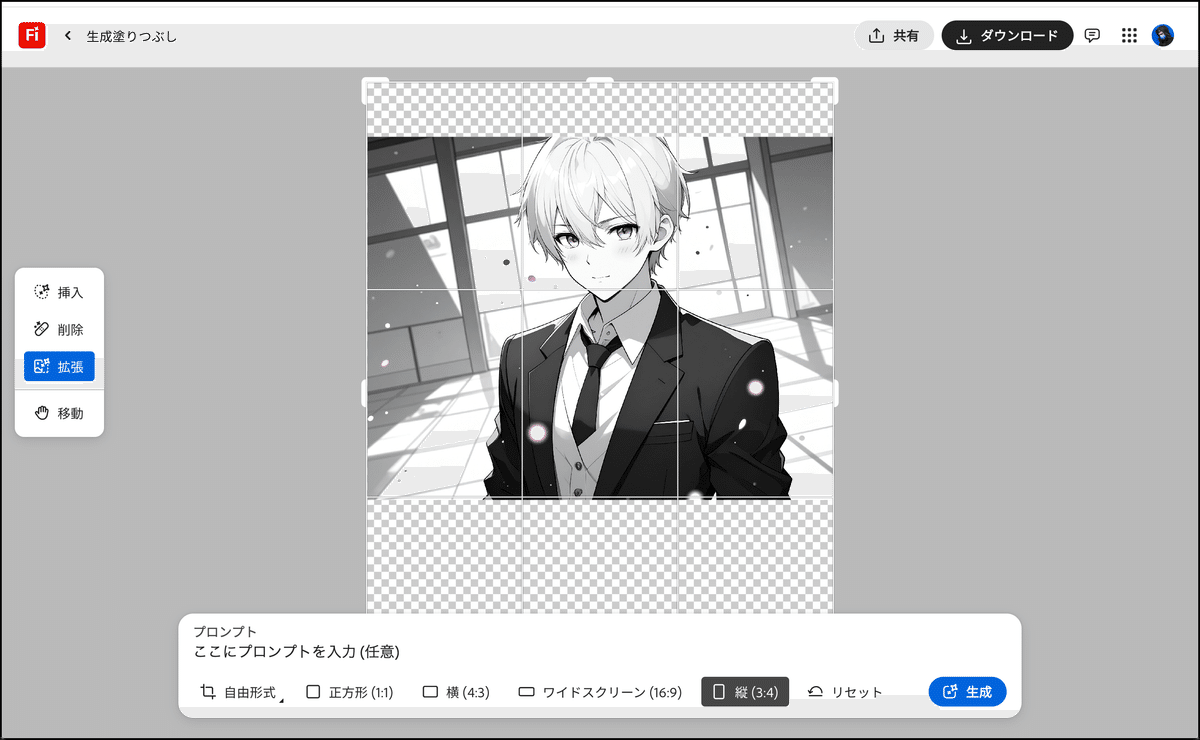

生成された画像は、Editorで部分修正や領域の拡張などを実行しながら、ビジュアルの完成度を高めていきます。

上記の検証でプロンプト構造「Subject + Scene + Style」の「Scene」を省略したのは、後処理の方が完成度を上げられることが分かったからです。

Midjourney v7では、Editorを使用します。

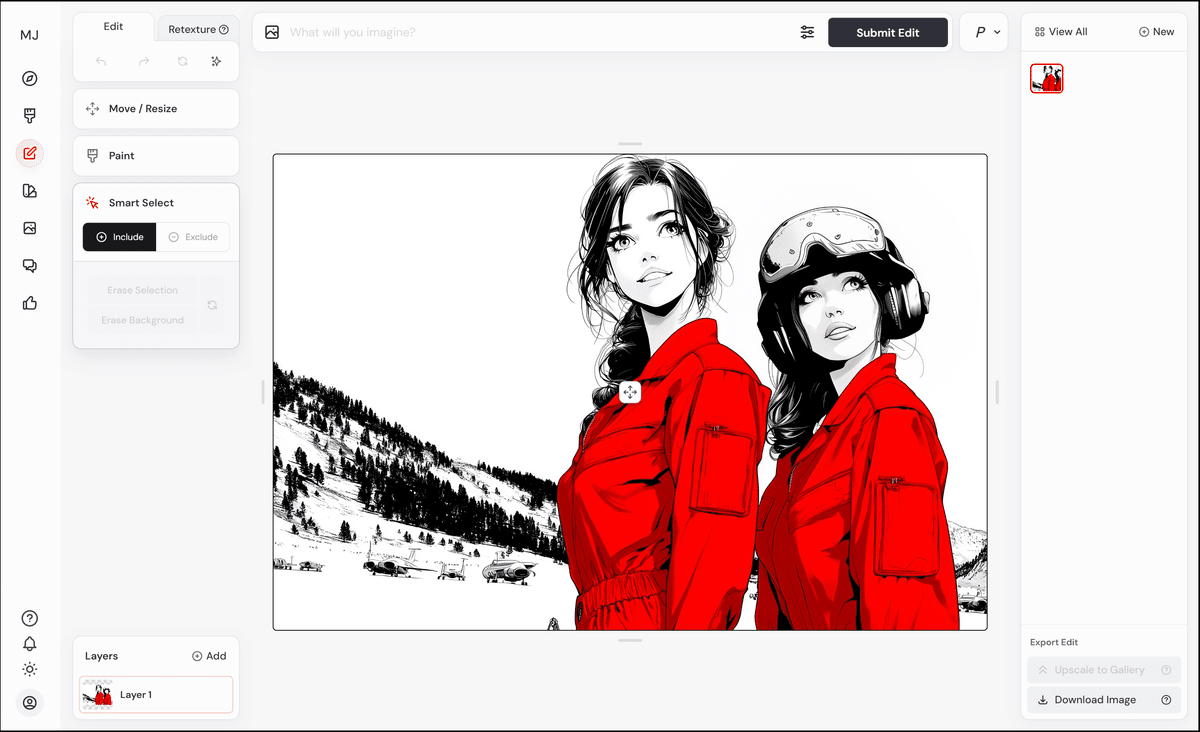

Smart Selectで被写体をマスキングします。

ピンを打ちながら選択範囲を作成。大まかなに選択できればOKです。

背景を削除します。

被写体のエッジが削れていても問題ありません。被写体が認識できれば問題なく処理できます。

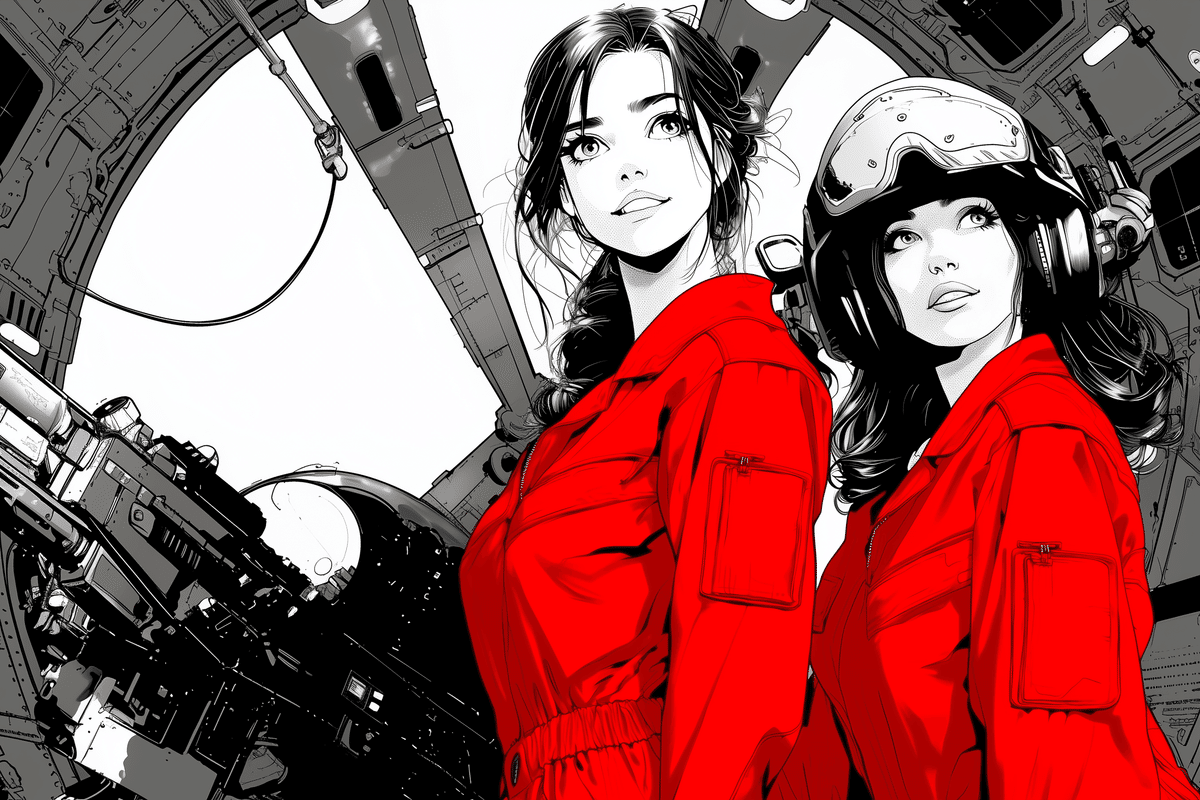

背景のプロンプトは以下のとおりです。

追加プロンプト:

Manga style, The interior of a space station with a space age design, black and white, strong outline, No dither, No fill, No solids, elegant sweeping inked lines --ar 16:9 --raw --stylize 500 --v 7

背景画のプロンプトを入力して実行します。

マスキングされたキャラクターの領域は、再生成されないので、完全に同一のキャラクターです。Photoshopで超高精度の切り抜き合成をしたような仕上がり。

※正確に言うと、キャラクターをマスキングした境界線部分は再生成されていますので若干変わっていますが許容可能なレベルだと思います。

今回の検証です。

プロンプト構造は「Subject + Scene + Style」

ChatGPT o3で画風制御プロンプト「Style」を開発

画風制御プロンプト「Style」に被写体プロンプト「Subject」を追加して画像生成する

被写体をマスキングし、背景プロンプト「Scene」をリミックス

今までは、画像生成を繰り返すと(画面全体が再生成されるため)被写体も影響を受けていましたが、Midjourney Editorを使用すれば、被写体を守ることができ、同一のキャラクターを保持して背景を入れ替えることが可能になります。

Midjourney v7の新機能「Omni Reference」を使用すれば、ほぼ同一のキャラクターを様々なシーンに登場させることが可能ですが、リファレンスは1つのキャラクターに対して喜怒哀楽など、6〜12画像程度のバリエーションが必要です。

写真表現だと1つのリファレンスで表現できますが、漫画スタイルはうまくいきませんので複数のリファレンスを使い分けることになります。

Omni Referenceの検証については、以下の記事をご覧ください。

この記事の続き:

更新日:2025年5月4日(日)/公開日:2025年5月4日(日)